933

933

1397

1397

919

919

128

128

791

791

1854

1854

682

682

2910

2910

307

307

“相关推荐”对你有帮助么?

-

非常没帮助

非常没帮助 -

没帮助

没帮助 -

一般

一般 -

有帮助

有帮助 -

非常有帮助

非常有帮助

热门文章

-

python系列文章(基础,应用,后端,运维,自动化测试,爬虫,数据分析,可视化,机器学习,深度学习系列内容)

201783

201783

-

java使用javax.mail包发送电子邮件:设置账号、密码、主题、文本、附件

164663

164663

-

python测试系列教程——python+Selenium+chrome自动化测试框架

101804

101804

-

python神经网络案例——CNN卷积神经网络实现mnist手写体识别

77128

77128

-

kafka实战教程(python操作kafka),kafka配置文件详解

73576

73576

分类专栏

-

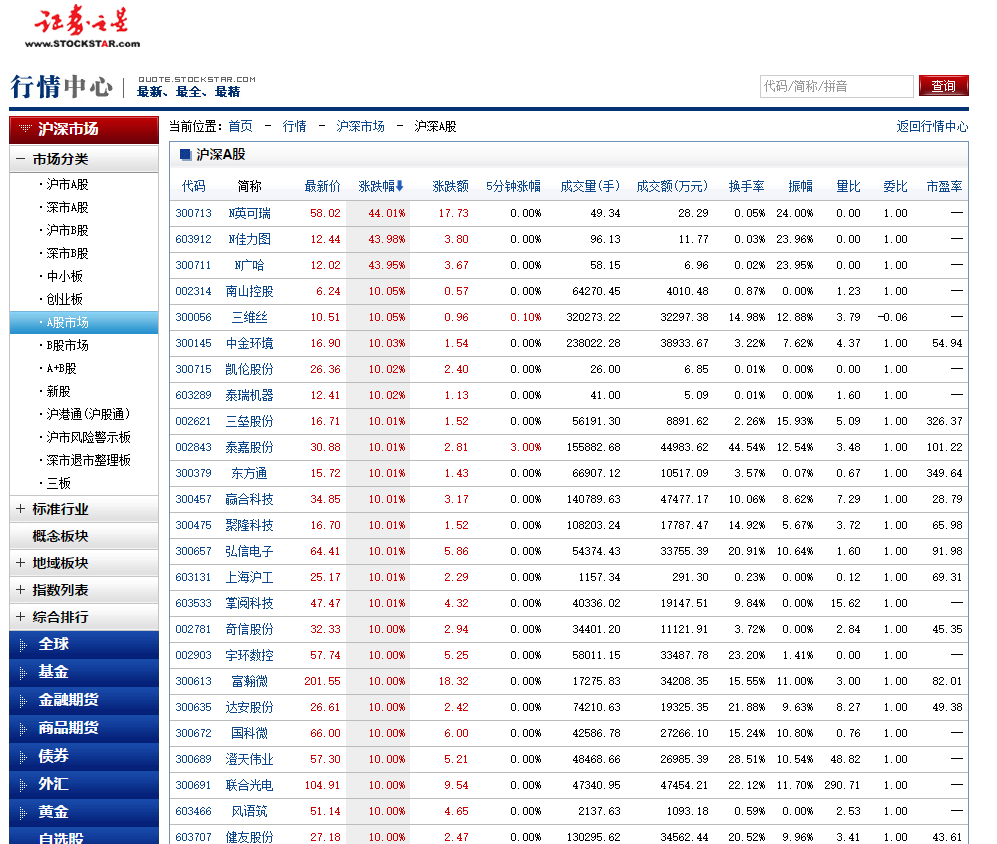

代码炒股,量化交易

付费

1篇

代码炒股,量化交易

付费

1篇

-

开源

开源

-

matlab2c数据分析 c++ 系列课程

105篇

matlab2c数据分析 c++ 系列课程

105篇

-

OPNET网络仿真分析 10篇

-

c++ 开发 手册

10篇

c++ 开发 手册

10篇

-

go开发

3篇

go开发

3篇

-

python 机器学习 后端 爬虫 系列课程

183篇

python 机器学习 后端 爬虫 系列课程

183篇

-

大数据 系列课程

63篇

大数据 系列课程

63篇

-

云原生/微服务架构/运维 系列课程

163篇

云原生/微服务架构/运维 系列课程

163篇

-

java 系列课程

50篇

java 系列课程

50篇

-

Echarts数据可视化

26篇

Echarts数据可视化

26篇

-

android安卓 开发 手册

40篇

android安卓 开发 手册

40篇

-

js 系列课程

44篇

js 系列课程

44篇

-

css 开发 手册

9篇

css 开发 手册

9篇

-

jquery 开发 手册

35篇

jquery 开发 手册

35篇

-

c# 系列课程

45篇

c# 系列课程

45篇

-

jquery mobile 开发 手册

27篇

jquery mobile 开发 手册

27篇

-

闲情雅致

20篇

闲情雅致

20篇

最新评论

最新文章

- github 仓库中的多次代码提交,如何合并为一次的代码提交

- 京东、携程、B站、唯品会等大厂都在探索哪些大数据新技术应用?

- ai个性化 国庆 头像 合成

目录

目录

分类专栏

-

代码炒股,量化交易

付费

1篇

代码炒股,量化交易

付费

1篇

-

开源

开源

-

matlab2c数据分析 c++ 系列课程

105篇

matlab2c数据分析 c++ 系列课程

105篇

-

OPNET网络仿真分析 10篇

-

c++ 开发 手册

10篇

c++ 开发 手册

10篇

-

go开发

3篇

go开发

3篇

-

python 机器学习 后端 爬虫 系列课程

183篇

python 机器学习 后端 爬虫 系列课程

183篇

-

大数据 系列课程

63篇

大数据 系列课程

63篇

-

云原生/微服务架构/运维 系列课程

163篇

云原生/微服务架构/运维 系列课程

163篇

-

java 系列课程

50篇

java 系列课程

50篇

-

Echarts数据可视化

26篇

Echarts数据可视化

26篇

-

android安卓 开发 手册

40篇

android安卓 开发 手册

40篇

-

js 系列课程

44篇

js 系列课程

44篇

-

css 开发 手册

9篇

css 开发 手册

9篇

-

jquery 开发 手册

35篇

jquery 开发 手册

35篇

-

c# 系列课程

45篇

c# 系列课程

45篇

-

jquery mobile 开发 手册

27篇

jquery mobile 开发 手册

27篇

-

闲情雅致

20篇

闲情雅致

20篇

Python领域优质创作者

Python领域优质创作者

不曾呀.: 购买opnet书籍,已赞赏 1928226536@qq.com

Yigezxy: https://echarts.apache.org/zh/cheat-sheet.html 官网这个也不错

WDddd986: 老师您好,在第二部分搜索部分,select这些不是SQL里面的语句吗,请问在python里如何运行搜索

sinat_16643333: matlab2c动态链接库下载的链接怎么跳转到了一个大众娱乐网站

华夏林更新: 购买opnet书籍,已赞赏,834780329@qq.com